Z okazji Światowego Dnia Świadomości Dostępności (Global Accessibility Awareness Day) Google postanowiło nie tylko uczcić ten dzień słowami – ale przede wszystkim nowymi funkcjami w Androidzie, Chrome i narzędziami dla twórców oprogramowania. Jednocześnie, nieco bardziej komercyjnie, YouTube pokazało jak wykorzystać AI do… skuteczniejszego wyświetlania reklam. Bo kto powiedział, że technologia nie może być jednocześnie empatyczna i przedsiębiorcza?

Android jeszcze bardziej „widzi” i „słyszy”

Na smartfonach z Androidem pojawiają się nowe możliwości wykorzystania AI – tym razem dla osób z problemami ze wzrokiem lub słuchem. TalkBack, czyli czytnik ekranu, wzbogacony został o integrację z Gemini, modelem AI od Google. Co to oznacza w praktyce? Jeśli ktoś wyśle Ci zdjęcie gitary, telefon nie tylko opisze, że to gitara, ale odpowie też na pytanie o jej kolor, markę czy to, co znajduje się w tle. I to wszystko bez alt-tekstu!

Pojawiła się też funkcja „Expressive Captions”, która potrafi nie tylko napisywać, ale też „czytać emocje” z mowy. Jeśli ktoś w filmiku mówi „nooooo” – AI zaznaczy długość tego przeciąganego słowa. Wreszcie będzie wiadomo, czy trener komentuje „amaaazing shot” czy tylko „ok”. Nowość trafia na Androida 15 w USA, Wielkiej Brytanii, Kanadzie i Australii.

Euphonia rozwija mowę – po swojemu

Projekt Euphonia wystartował jeszcze w 2019 roku, by wspierać osoby z nietypową mową w komunikacji ze światem cyfrowym. Teraz jego zasięg się rozszerza – deweloperzy mogą korzystać z otwartego repozytorium na GitHubie, trenować modele i tworzyć nowe aplikacje, bardziej zrozumiałe dla osób mówiących w niestandardowy sposób.

Szczególnie ciekawie wygląda współpraca z University College London i nowo utworzonym Centrum Cyfrowej Inkluzji Językowej (CDLI). Dzięki wsparciu Google.org powstaną zbiory danych i modele mowy w aż 10 afrykańskich językach. Kto wie, może za kilka lat telefon będzie lepiej rozumiał suahili niż niejeden turysta.

Chromebooki coraz bardziej szkolne

Google dorzuca też nowości do Chromebooków – szczególnie tych używanych przez uczniów. W aplikacji Bluebook do zdawania testów (np. SAT), dostępne będą wszystkie wbudowane funkcje dostępności: od czytnika ekranu ChromeVox po dyktowanie tekstu. Czyli testy będą nie tylko trudne, ale przynajmniej bardziej dostępne.

Chrome z OCR-em i zoomem

Chrome doczekał się funkcji rozpoznawania tekstu w zeskanowanych PDF-ach – dzięki OCR można teraz nie tylko je przeczytać, ale i przeszukiwać. Do tego dochodzi „Page Zoom” – czyli powiększanie tekstu bez rozjeżdżania się strony, również na Androidzie. Mała rzecz, a cieszy – jak lupa w kieszeni.

YouTube wie, kiedy jesteś najbardziej skupiony. I wtedy wkleja reklamę

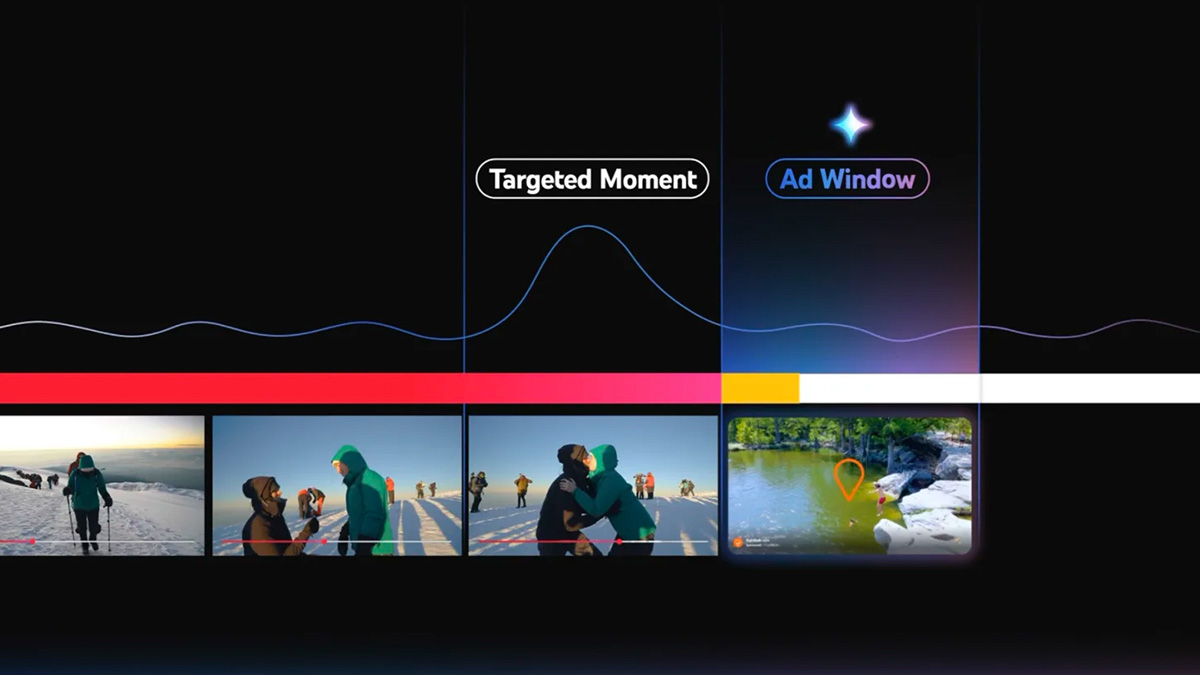

Na drugim biegunie innowacji – czyli w świecie reklam i klików – YouTube wprowadza narzędzie „Peak Points”. Dzięki AI od Google (tak, chodzi o Gemini), reklamy będą pojawiać się tuż po momentach, w których użytkownik jest najbardziej zaangażowany.

Model analizuje obraz, dźwięk i transkrypcję, by wykryć tzw. szczytowe punkty uwagi. Reklama wyświetlona zaraz po takim momencie ma większą szansę na kliknięcie. Z perspektywy twórców – lepszy CTR, z perspektywy widza – być może jeszcze bardziej trafione reklamy. A przynajmniej teoretycznie.

Funkcja na razie dostępna jest w wersji pilotażowej, ale do końca roku ma zostać szerzej udostępniona. Google wyraźnie pokazuje, że zarabianie na AI to dziś nie tylko trend, ale konkretna strategia. I jak mawiał pewien stary marketingowiec: „Ważne nie kiedy mówisz, ale kiedy ktoś naprawdę słucha”.