W świetle ostatnich wydarzeń, piątka demokratycznych senatorów zwróciła się z pytaniem do CEO OpenAI, Sama Altmana, dotyczącym praktyk bezpieczeństwa i zatrudnienia w firmie.

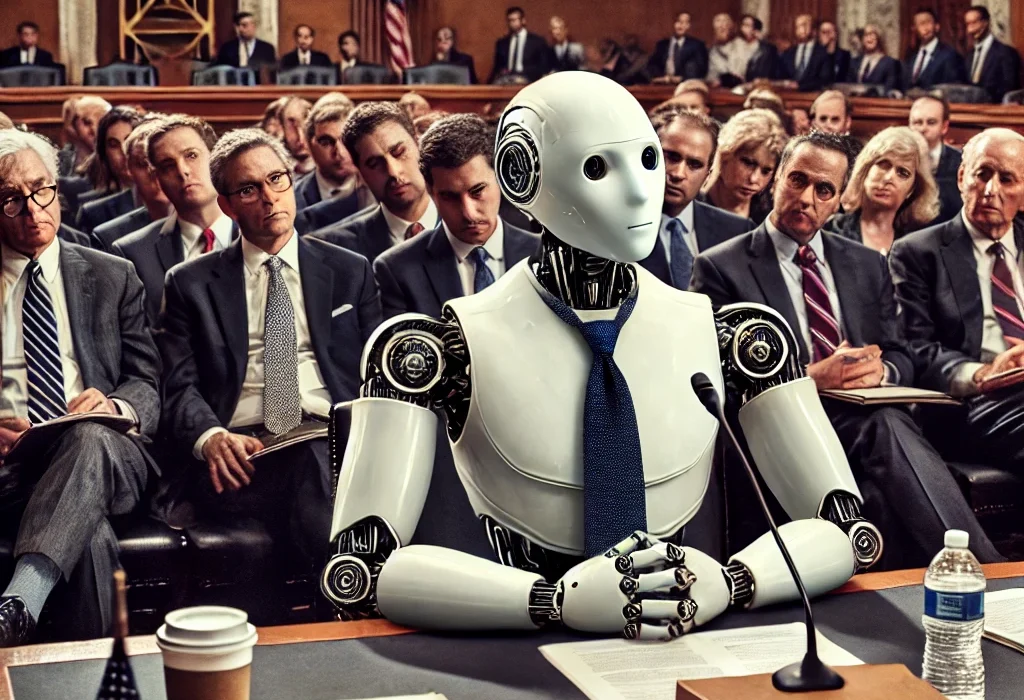

W odpowiedzi na niedawne doniesienia, które podważają zaangażowanie OpenAI w bezpieczny i odpowiedzialny rozwój sztucznej inteligencji, pięciu czołowych senatorów Partii Demokratycznej wysłało list z zapytaniami do Sama Altmana, dyrektora generalnego OpenAI. List podpisali Brian Schatz, Ben Ray Luján, Peter Welch, Mark R. Warner oraz Angus S. King Jr., co świadczy o powadze sytuacji.

Senatorowie podkreślają, że bezpieczeństwo AI jest kluczowe dla konkurencyjności gospodarczej i pozycji geopolitycznej kraju. Wspominają również o współpracy OpenAI z rządem USA i agencjami bezpieczeństwa narodowego w zakresie tworzenia narzędzi cyberbezpieczeństwa, co tylko podkreśla krytyczne znaczenie bezpiecznych systemów AI.

„Bezpieczeństwo narodowe i gospodarcze to jedne z najważniejszych obowiązków rządu Stanów Zjednoczonych, a systemy AI, które są niezabezpieczone lub podatne na zagrożenia, są nie do przyjęcia,” czytamy w liście.

Oto niektóre z kluczowych obszarów, na które senatorowie chcą uzyskać odpowiedzi do 13 sierpnia 2024 roku:

- Zobowiązanie OpenAI do przeznaczenia 20% swoich zasobów obliczeniowych na badania nad bezpieczeństwem AI.

- Stanowisko firmy wobec umów o nieujawnianiu dla obecnych i byłych pracowników.

- Procedury umożliwiające pracownikom zgłaszanie obaw dotyczących cyberbezpieczeństwa i bezpieczeństwa.

- Protokoły bezpieczeństwa mające na celu zapobieganie kradzieży modeli AI, badań lub własności intelektualnej.

- Przestrzeganie przez OpenAI własnego Kodeksu Postępowania Dostawców w zakresie polityki antyretaliacyjnej i kanałów dla sygnalistów.

- Plany niezależnych testów i ocen systemów OpenAI przed ich wprowadzeniem.

- Zobowiązanie do udostępniania przyszłych modeli bazowych agencjom rządowym USA do testów przedwdrożeniowych.

- Praktyki monitorowania po wdrożeniu i wnioski z wdrożonych modeli.

- Plany publicznego ujawniania retrospektywnych ocen wpływu wdrożonych modeli.

- Dokumentacja dotycząca spełniania dobrowolnych zobowiązań w zakresie bezpieczeństwa i bezpieczeństwa przed administracją Bidena.

Kontrowersje wokół OpenAI, w tym doniesienia o wewnętrznych sporach dotyczących praktyk bezpieczeństwa oraz rzekomych naruszeniach cyberbezpieczeństwa, sprawiają, że odpowiedź firmy na te zapytania może mieć znaczące implikacje dla przyszłości zarządzania AI oraz relacji między firmami technologicznymi a organami nadzoru rządowego.

W kontekście zbliżających się wyborów prezydenckich w USA, gdzie Kamala Harris może zostać następnym prezydentem, jej podejście do regulacji AI i dużych technologii nabiera szczególnego znaczenia. „Zagrożenia, które również wymagają naszej reakcji… kiedy ludzie na całym świecie nie mogą odróżnić faktu od fikcji z powodu zalewu mitów i dezinformacji wspomaganych przez AI,” mówiła Harris podczas szczytu bezpieczeństwa AI w Wielkiej Brytanii.

W odpowiedzi na te wyzwania, Chelsea Alves, konsultantka z UNMiss, stwierdziła: „Podejście Kamali Harris do regulacji AI i dużych technologii jest zarówno aktualne, jak i krytyczne, gdy wkracza do wyścigu prezydenckiego. Jej polityki mogą wyznaczać nowe standardy, jak poruszać się po złożonościach nowoczesnej technologii i prywatności osobistej.”

Debata na temat regulacji AI i środków bezpieczeństwa jest coraz bardziej intensywna, a list senatorów odnosi się do dobrowolnych zobowiązań, które wiodące firmy AI złożyły Białemu Domowi w zeszłym roku, przedstawiając je jako „ważny krok w kierunku budowania tego zaufania” w bezpieczeństwo i bezpieczeństwo AI.