Wielkie modele AI to nie tylko więcej danych i większe modele – to również więcej ciepła. A z tym ciepłem trzeba coś zrobić, bo jak mówi stare porzekadło informatyków: “im goręcej, tym wolniej” – a przecież nikt nie chce, żeby serwerownia działała jak piekarnik.

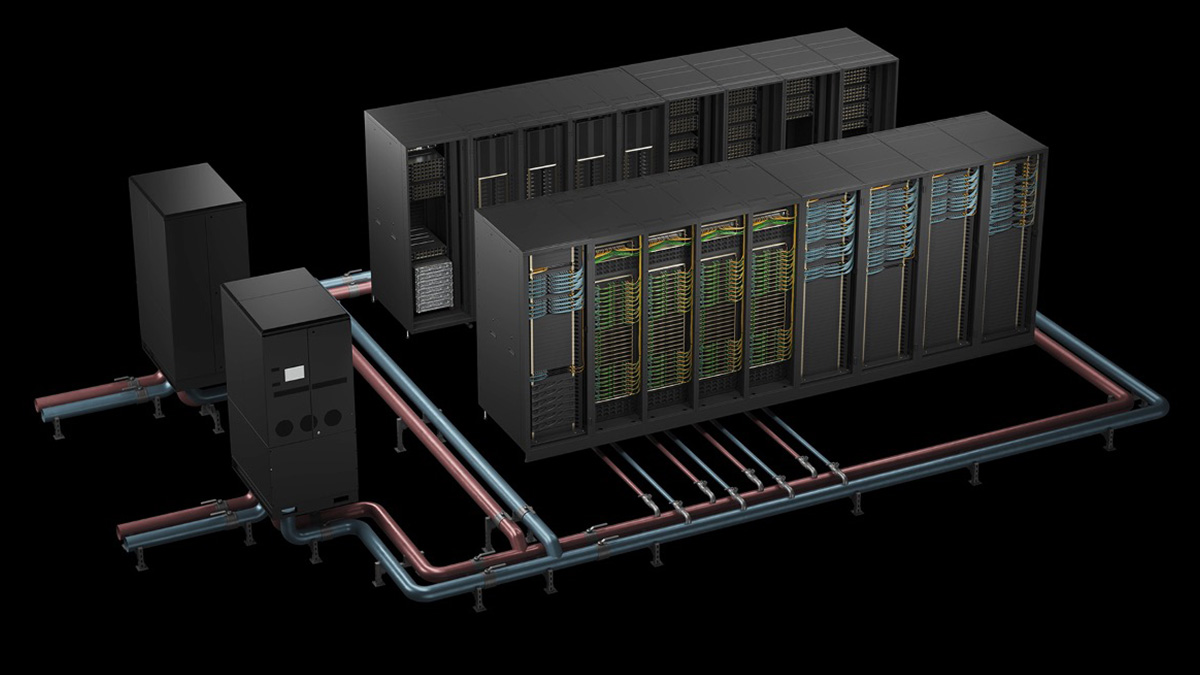

NVIDIA zaprezentowała nowe systemy GB200 NVL72 i GB300 NVL72 oparte na platformie Blackwell. Brzmi technicznie? Tak, ale spokojnie – tu chodzi o coś bardzo konkretnego: chłodzenie cieczą. To nie tylko futurystyczna wizja, ale realna alternatywa dla tradycyjnych systemów chłodzenia powietrzem, które powoli przestają wyrabiać przy gęsto upakowanych, energetycznie łakomych AI-serwerach.

Powietrze już nie wystarcza

Dawniej wystarczało 20 kW na szafę serwerową. Teraz? 135 kW i więcej. To tak jakby ktoś kazał ci chłodzić kuchenkę indukcyjną wiatrakiem biurkowym – nie zadziała. Dlatego NVIDIA stawia na chłodzenie cieczą. Systemy Blackwell potrafią odprowadzać ciepło znacznie skuteczniej, co oznacza mniej potrzeby używania mechanicznych chłodnic, mniej energii i… ogromne oszczędności.

GB200 NVL72 – mniejsze zużycie, większa wydajność

Platforma GB200 NVL72 umożliwia:

- 40x większy potencjał przychodowy,

- 30x wyższą przepustowość,

- 25x większą efektywność energetyczną

- i… uwaga: 300x lepszą efektywność wodną niż standardowe systemy chłodzone powietrzem.

Dla przeciętnego centrum danych to jak przesiadka z parowego silnika do Tesli – mniej hałasu, więcej mocy, a rachunki za wodę i prąd nie przyprawiają o zawał.

A jak to działa?

Ciecz trafia bezpośrednio do chipów – bez etapu „wiatraczek-dmucha-i-ma-nadzieję”. Ciepło wędruje przez system wymienników do instalacji chłodzenia całej placówki. Ponieważ ciecz przewodzi ciepło znacznie lepiej niż powietrze, cały system może pracować przy wyższych temperaturach bez obawy o przegrzanie. Mniej chłodziwa, mniej wody, więcej efektywności. I ciszej.

Szacuje się, że centrum danych o mocy 50 MW może oszczędzić ponad 4 miliony dolarów rocznie tylko dzięki systemowi GB200 NVL72. A przypomnijmy, że samo chłodzenie to czasem nawet 40% całkowitego zużycia energii takich placówek. Tu nie chodzi o „trochę mniej”, ale o ćwierć miliona dolarów oszczędności na każdy megawat.

Co jeszcze chłodzi?

Na rynku funkcjonują też inne metody:

- Chłodzenie mechaniczne – skuteczne, ale energożerne.

- Chłodzenie ewaporacyjne – mniej prądu, ale pochłania tony wody.

- Dry coolery – dobre na pustyni, kiepskie w upałach.

- Systemy z pompowanym czynnikiem chłodzącym – wydajne, kompaktowe i bez użycia wody.

Każda z metod ma swoje plusy i minusy – wszystko zależy od tego, gdzie stoi data center, ile ma mocy i jak bardzo właściciel dba o rachunki.

Przyszłość AI to chłodzenie cieczą

Wspierane przez firmy takie jak Schneider Electric, CoolIT Systems czy Boyd, rozwiązania NVIDIA są coraz chętniej wdrażane przez operatorów chmurowych – na przykład AWS, który dzięki nim zmniejsza zużycie energii o niemal połowę, zwiększając jednocześnie moc obliczeniową.

Ale to nie koniec – NVIDIA bierze udział w rządowym programie COOLERCHIPS, gdzie celem jest stworzenie modułowych centrów danych z chłodzeniem nowej generacji. Mają one być tańsze, wydajniejsze i… nieprzegrzewające się w upalne dni.

Wniosek? Jeśli przyszłość AI ma być gorąca, to lepiej, żeby jej infrastruktura była zimna. I najlepiej chłodzona cieczą. Jak w sportowym silniku – moc i precyzja, ale bez zagotowania.