NVIDIA właśnie dorzuciła do swojego arsenału nową perełkę – Blackwell Ultra, czyli najświeższego członka rodziny układów GPU Blackwell. To nie jest zwykły lifting, tylko poważny skok technologiczny, którego celem jest jedno: dać sztucznej inteligencji jeszcze większą moc obliczeniową i wydajność. A że przy okazji może zmienić oblicze centrów danych i tzw. „AI factories”? To już szczegół – ale jakże ważny.

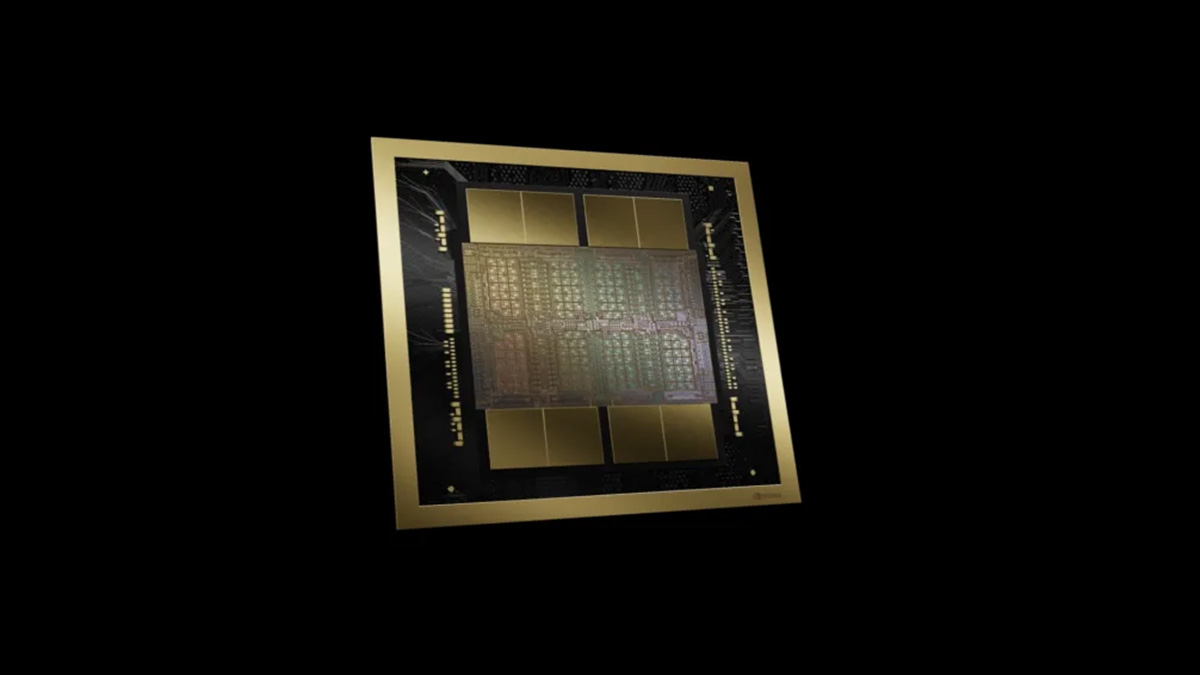

Silikonowa sztuka składania

Najciekawsza innowacja to podwójny układ krzemowy – Blackwell Ultra to tak naprawdę dwa „kawałki” scalaka połączone interfejsem NV-HBI (10 TB/s przepustowości). Dla porównania, Hopper – poprzednik – miał tylko jeden taki kawałek i „zaledwie” 80 miliardów tranzystorów. Tu mamy aż 208 miliardów. Efekt? Jedna karta, a moc jak z dwóch, przy zachowaniu klasycznego programowania CUDA, które deweloperzy znają od dwóch dekad.

Tensor Cores – serce od nowa przepompowane

Pamiętacie czasy, gdy Tensor Cores pojawiły się pierwszy raz w architekturze Volta i zrewolucjonizowały deep learning? Teraz dostajemy ich piątą generację. Blackwell Ultra ma łącznie 640 takich rdzeni, każdy z własną porcją pamięci blisko jednostek obliczeniowych. Dodajmy do tego nowy format NVFP4 – 4-bitowe liczby zmiennoprzecinkowe, które są niemal tak dokładne jak FP8, ale zajmują o połowę mniej miejsca. W praktyce oznacza to większe modele w tej samej pamięci i jeszcze szybsze wnioski AI.

A skoro o pamięci mowa…

Pamięć większa niż niejedna biblioteka

Blackwell Ultra oferuje 288 GB pamięci HBM3E na pojedynczy układ. To 3,6 raza więcej niż H100 i o połowę więcej niż zwykły Blackwell. Do tego przepustowość na poziomie 8 TB/s – czyli mniej więcej tyle, ile byśmy potrzebowali, żeby w kilka sekund wczytać całą Wikipedię. No może przesadzam… ale tylko trochę.

Szybsza uwaga = szybsze myślenie

Transformery – a więc fundament modeli językowych – bazują na mechanizmie attention. Problem w tym, że właśnie tam często robi się wąskie gardło. Dlatego NVIDIA podwoiła wydajność jednostek odpowiedzialnych za tzw. softmax w warstwie uwagi. Efekt? Do 2x szybsze przetwarzanie sekwencji, a więc krótszy czas „do pierwszego tokenu” w czacie AI i niższe koszty per zapytanie.

Fabryki AI w praktyce

Nie byłoby Blackwell Ultra bez infrastruktury wokół niego. NVIDIA stawia na NVLink 5 (1,8 TB/s per GPU), nowe konfiguracje rackowe i superchip Grace Blackwell Ultra, łączący CPU i dwa GPU z aż 1 TB zunifikowanej pamięci. W pełnych systemach, takich jak GB300 NVL72, mówimy już o wydajności w skali exaFLOPS, czyli miliardów miliardów operacji na sekundę. To są moce obliczeniowe, które jeszcze parę lat temu pojawiały się w opisach superkomputerów – a teraz mieszczą się w szafie serwerowej.

Bezpieczeństwo, niezawodność i multimodalność

Blackwell Ultra to też ukłon w stronę przedsiębiorstw – GPU można dzielić na mniejsze instancje (MIG), wspiera szyfrowane połączenia CPU-GPU, a także przyspiesza wbudowane dekodowanie wideo i obrazów (AV1, JPEG). Dzięki temu świetnie sprawdzi się nie tylko w trenowaniu modeli językowych, ale i w multimodalnych zastosowaniach: od przetwarzania wideo w czasie rzeczywistym po analitykę ogromnych zbiorów danych.

I co z tego?

W skrócie: Blackwell Ultra to nie kolejny krok, tylko duży skok naprzód. 50% więcej pamięci, 50% więcej mocy obliczeniowej, lepsza efektywność energetyczna i architektura zaprojektowana od początku z myślą o AI. To GPU, które ma zamienić obecne centra danych w prawdziwe fabryki inteligencji.

NVIDIA obiecuje, że to właśnie Ultra stanie się fundamentem dla modeli nowej generacji – większych, szybszych i dostępnych w czasie rzeczywistym. A patrząc na liczby, trudno w to nie wierzyć.