OpenAI wypuściło właśnie dwa nowe modele z serii „o”: o3 i o4-mini. I nie chodzi tu bynajmniej o kolejny cyferkowy upgrade w stylu „szybciej, więcej, lepiej”. Te modele mają myśleć zanim coś powiedzą. A to, przy obecnym tempie życia (i internetu), zakrawa niemal na filozofię.

Modele o3 i o4-mini to najinteligentniejsze jak dotąd „rozumujące” modele stworzone przez OpenAI. Po raz pierwszy ChatGPT w tej wersji potrafi w pełni korzystać z zestawu narzędzi: od przeszukiwania internetu, przez analizę plików i danych w Pythonie, po rozumienie obrazów i generowanie grafik. I co ważne – wie kiedy i jak z tych narzędzi korzystać, żeby odpowiedź miała ręce, nogi i jeszcze sensowny format.

Czyli: możesz wrzucić mu zdjęcie z rozmazaną notatką z tablicy, plik Excela i pytanie o trend w rynku energii – i on sobie poradzi. A do tego zrobi to zazwyczaj w mniej niż minutę.

o3 – mózgowiec z potencjałem konsultanta McKinseya

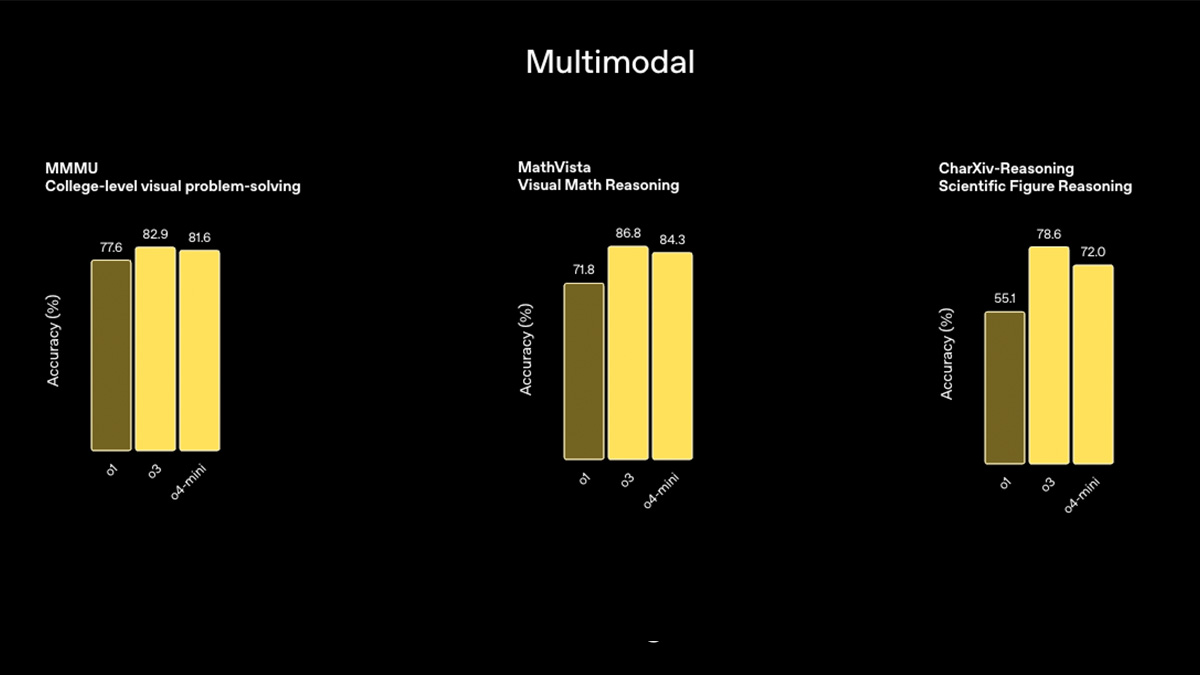

Model o3 to obecnie najmocniejszy gracz w portfolio OpenAI jeśli chodzi o rozumowanie. Rozpycha się na benchmarkach takich jak Codeforces, SWE-bench i MMMU – i robi to bez żadnych specjalnych ułatwień. Świetnie radzi sobie z analizą wizualną, np. wykresów i diagramów, co czyni go idealnym partnerem nie tylko dla programistów, ale też dla konsultantów, naukowców i inżynierów.

Według zewnętrznych ekspertów, o3 popełnia o 20% mniej poważnych błędów niż jego poprzednik o1. A to już różnica, którą czuć w codziennej pracy. W szczególności wyróżnia się w zadaniach z zakresu biologii, matematyki, a nawet kreatywnego wymyślania hipotez.

o4-mini – mały, ale wariat

Nie każdy potrzebuje czołgu. Czasem wystarczy szybki skuter. o4-mini to mniejszy, szybszy i tańszy model, który mimo kompaktowych rozmiarów błyszczy w testach z matematyki, kodowania i analizy wizualnej. W najnowszym egzaminie AIME 2025 (tak, nawet AI musi coś zdawać) osiągnął 99,5% skuteczności, gdy miał dostęp do interpretera Pythona.

Choć model jest „mini”, to możliwości ma konkretne – w niektórych przypadkach przebija nawet większe modele, zwłaszcza jeśli chodzi o efektywność i szybkość działania. Jest też świetnym wyborem przy większym obciążeniu – tam, gdzie potrzeba wielu odpowiedzi na raz.

Modele, które naprawdę „widzą” obrazy

Nowością jest też to, że o3 i o4-mini potrafią nie tylko spojrzeć na obrazek, ale też się nad nim zastanowić. Interpretują szkice, tablice, a nawet nieostre zdjęcia, jakby były zrobione nie przez człowieka, a przez kota. Z pomocą narzędzi mogą te obrazy obracać, analizować i przetwarzać jako część procesu rozumowania.

Modele te potrafią nie tylko analizować i odpowiadać, ale też planować i reagować na bieżące informacje. Potrafią przeszukiwać sieć kilkakrotnie, łączyć dane z różnych źródeł, generować wykresy i teksty w jednym ciągu rozumowania.

Przykład? Zapytaj „Jakie będą prognozy zużycia energii latem na Mazowszu?” – model przeszuka dane, wygeneruje prognozę, stworzy wykres i wyjaśni, co wpłynęło na jego analizę.

Bezpieczeństwo – priorytet bez kompromisów

Wraz ze wzrostem możliwości, rośnie też odpowiedzialność. OpenAI mocno przebudowało system bezpieczeństwa – od lepszych mechanizmów odmawiania odpowiedzi na ryzykowne zapytania (np. tworzenie malware, zagrożenia biologiczne), po testy odporności zgodne z tzw. Frameworkiem Gotowości.

Nowe modele są też wyposażone w wewnętrzne mechanizmy nadzoru (np. reasoning LLM monitor), które pilnują, żeby nikt nie kombinował z jailbreakami czy niebezpiecznymi instrukcjami.

Narzędzie dla developerów i… terminalowców

OpenAI wypuściło również coś dla miłośników konsoli: Codex CLI – lekkiego agenta do kodowania z poziomu terminala. Działa lokalnie, pozwala modelom jak o3 czy o4-mini analizować zrzuty ekranu, szkice i kod źródłowy. Minimalistycznie, ale skutecznie.

A żeby podkręcić zainteresowanie, OpenAI rzuca na stół 1 milion dolarów w grantach dla tych, którzy stworzą coś ciekawego z Codex CLI.

Gdzie to wszystko znaleźć?

Modele o3 i o4-mini są już dostępne w ChatGPT dla użytkowników planów Plus, Pro i Team. Darmowi użytkownicy mogą testować o4-mini, wybierając opcję „Think” w kreatorze wiadomości.

Deweloperzy też mogą już korzystać z nowych modeli przez Chat Completions API oraz Responses API – ten ostatni wspiera funkcje takie jak web search, file search i interpreter kodu jako część procesu rozumowania.

Co dalej?

Wygląda na to, że OpenAI zmierza ku połączeniu dwóch światów: potężnego rozumowania serii „o” z konwersacyjnym luzem GPT. Przyszłe modele będą jeszcze lepsze w prowadzeniu naturalnych rozmów, jednocześnie wykonując złożone zadania w tle.

I kto wie – może kiedyś rzeczywiście będą w stanie same załatwić za nas sprawy, których nikt nie lubi: od rozliczeń podatkowych po rezerwację wakacji…