Jeszcze niedawno budowanie zaawansowanych workflow opartych o modele językowe było zarezerwowane dla programistów z co najmniej średnim poziomem frustracji i znajomości terminala. Ale czasy się zmieniają – a generatywna AI nie zwalnia tempa. Dzięki aplikacjom takim jak Langflow oraz integracji z lokalnym środowiskiem Ollama, nawet zupełny laik może stworzyć własnego agenta AI. I to bez pisania choćby jednej linijki kodu.

Generatywna AI? Tak, ale bez programowania

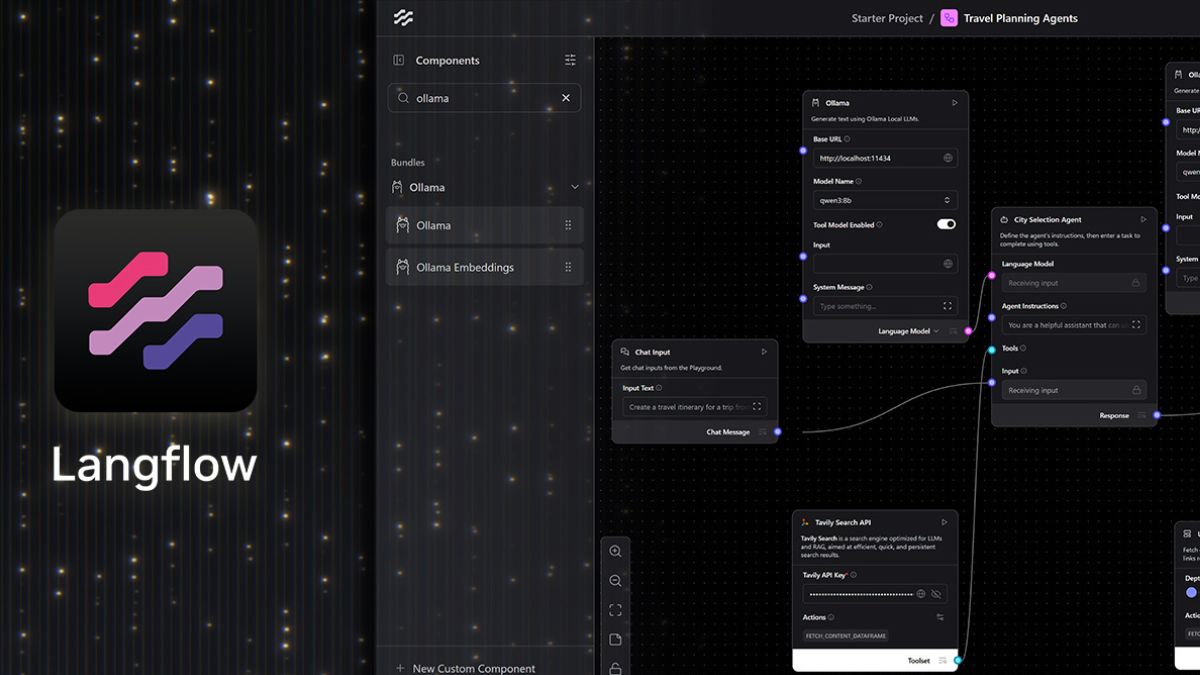

Langflow to platforma typu low-code (czyli „kliknij zamiast pisać”), która oferuje wizualny interfejs typu „przeciągnij i upuść”. Na jednym ekranie można połączyć różne komponenty – modele językowe, narzędzia, logikę sterującą, pamięć – tak, by stworzyć coś na kształt wirtualnego asystenta, który potrafi więcej niż tylko odpowiedzieć na pytanie o pogodę.

W przeciwieństwie do prostych chatbotów, które kończą rozmowę po jednym pytaniu, Langflow pozwala budować złożone systemy: analizujące pliki, przeszukujące wiedzę, wykonujące działania i reagujące na dynamiczne dane wejściowe. A wszystko to — uwaga — bez ani grama kodowania.

Lokalne workflowy z prywatnością na pierwszym miejscu

Ciekawostką jest możliwość uruchamiania workflowów lokalnie, bez udziału chmury. Dzięki Ollama i wsparciu dla kart graficznych NVIDIA RTX (zarówno tych gamingowych, jak i profesjonalnych), użytkownik zyskuje pełną kontrolę nad swoimi danymi — bez API, bez abonamentów, bez tokenów, bez internetu.

Co to oznacza w praktyce? Po pierwsze: pełna prywatność. Wszystkie dane, pliki i zapytania zostają na komputerze. Po drugie: wydajność — modele działają z niskimi opóźnieniami nawet przy dłuższych kontekstach. No i najważniejsze: wszystko jest za darmo.

Jak zacząć?

Twórcy Langflow zadbali o to, by proces startu był równie prosty, co parzenie herbaty. Wystarczy:

- Zainstalować Langflow na Windowsie.

- Zainstalować Ollama i uruchomić jeden z rekomendowanych modeli (np. Llama 3.1 8B lub Qwen3 4B).

- Odpalić Langflow, wybrać gotowy szablon (np. agenta podróży).

- Zamiast chmurowych modeli podpiąć lokalny runtime z Ollama.

- (Opcjonalnie) dorzucić dodatkowe funkcje: np. przeszukiwanie plików, systemowe komendy czy formatowanie odpowiedzi.

Brzmi jak składanie LEGO, prawda?

Jeśli więc marzyłeś kiedyś o własnym agencie AI, który nie tylko rozumie Twoje potrzeby, ale i nie wysyła Twoich danych do żadnych serwerów w chmurze — to właśnie dostałeś do ręki idealne narzędzia. Langflow i Ollama to duet, który może zrewolucjonizować nie tylko domowe eksperymenty z AI, ale i poważniejsze zastosowania automatyzacyjne. Bez linii kodu. Bez stresu. Bez limitów.