Czy sztuczna inteligencja może naprawdę pomóc programistom, zamiast tylko bawić się w cyfrowego papugę z opcją autouzupełniania? Zespół Mistral mówi: „Oczywiście, że tak” – i przedstawia Mistral Code. To narzędzie, które chce dać zespołom inżynierskim w dużych firmach nie tylko AI do pomocy, ale AI klasy premium – z zabezpieczeniami, zgodnością z politykami firmy i pełnym wsparciem.

Co to właściwie jest?

Mistral Code to nie jeden z tych pomysłów, które powstają na hackathonie po północy i kończą jako zapomniane repo na GitHubie. To kompletny pakiet: asystent w IDE, lokalna instalacja, integracje enterprise i – co najważniejsze – wszystko pod pełną kontrolą zespołów IT.

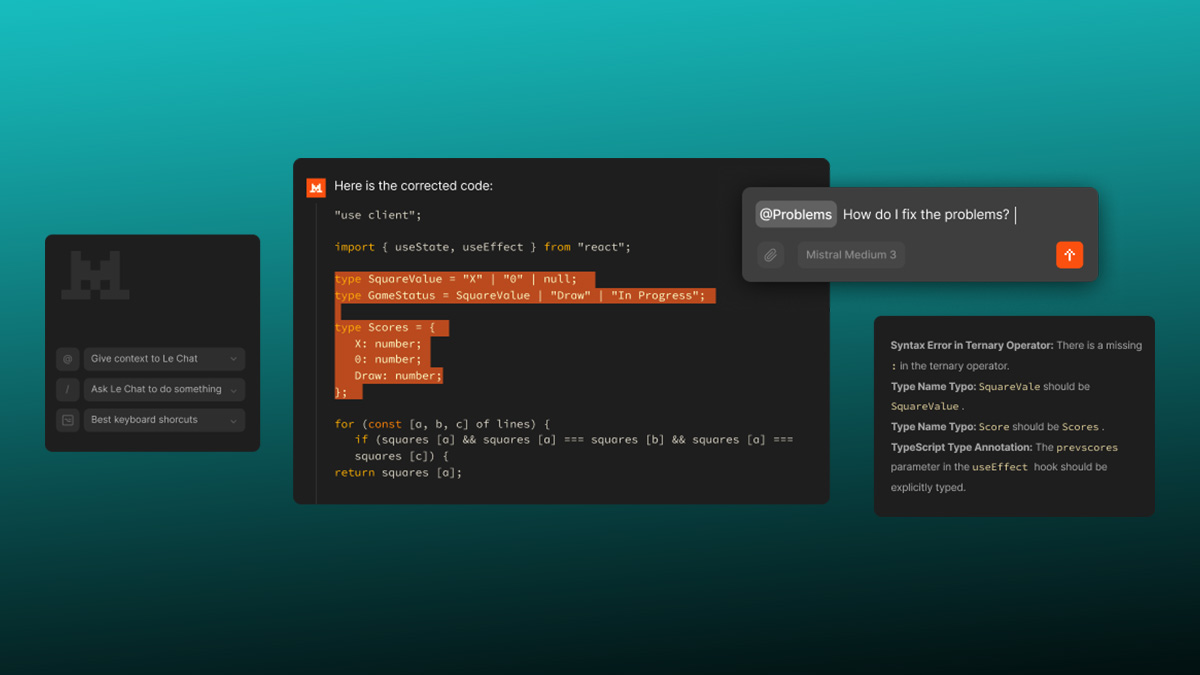

Narzędzie opiera się na otwartoźródłowym projekcie Continue, ale jest wzmocnione o to, co w korporacyjnej rzeczywistości niezbędne: widoczność, kontrola i zgodność z regulacjami. Obecnie dostępne jest w wersji beta dla JetBrains i VSCode. Na ogólną dostępność trzeba jeszcze chwilę poczekać – ale jak mawia stare programistyczne przysłowie: „lepiej dobrze przetestować, niż później łatać w produkcji”.

Po co w ogóle to zbudowano?

Celem Mistral Code było stworzenie narzędzia, które pomoże programistom nie tylko szybciej pisać kod, ale i lepiej zarządzać całym cyklem pracy – od uzupełnień w czasie rzeczywistym, przez refaktoryzację, aż po pełne zadania. Co więcej, można je uruchomić w chmurze, na dedykowanej infrastrukturze albo całkowicie offline – w środowiskach odizolowanych (czyt. tajne jak archiwa NSA).

I tu pojawia się ważna różnica: Mistral Code to nie SaaS z trzema różnymi SLA i czterema supportami, z których każdy odsyła do innego. To jeden dostawca, jedna odpowiedzialność, jedno API do rządzenia wszystkimi (i kodem też).

Cztery powody, dla których wcześniejsze „copiloty” nie dawały rady

Zespół Mistral zapytał decydentów IT, inżynierów platformowych i CISO, dlaczego tak wiele wdrożeń AI kończy się na etapie „proof of concept”. Odpowiedzi? Zaskakująco powtarzalne:

- Brak integracji z wewnętrznymi repozytoriami.

- Ograniczone możliwości dostosowania modeli.

- Funkcjonalność kończąca się na „podpowiedz nazwę zmiennej”.

- Rozdrobnione SLA i wsparcie techniczne.

I tu wchodzi Mistral Code – cały na biało, z modelem, pluginem, panelem administracyjnym i wsparciem 24/7. Wszystko w jednym ekosystemie.

Architektura: Cztery muszkieterowie kodowania

Na pokładzie znajdziemy cztery modele:

- Codestral – do autouzupełniania i „fill-in-the-middle”

- Codestral Embed – do wyszukiwania i przeszukiwania kodu

- Devstral – do bardziej „agentowego” podejścia do kodowania

- Mistral Medium – do asysty konwersacyjnej

I teraz crème de la crème: modele można dostosować, dostroić, a nawet „odchudzić”, tworząc własne warianty – coś, czego zamknięte rozwiązania zwyczajnie nie oferują.

Działa to z ponad 80 językami programowania i potrafi analizować pliki, różnice w Git, dane z terminala i zgłoszenia z issue trackera. Aż chce się powiedzieć: AI, która naprawdę koduje, a nie tylko udaje, że coś wie o Pythonie.

IT też coś z tego ma

Dla menadżerów IT przygotowano panel administracyjny z zarządzaniem dostępami, analizą wykorzystania, logami i pełną obserwowalnością. Innymi słowy: AI w kodzie, ale nie na dziko – tylko z pełną kontrolą i dokumentacją.

Mistral Code już działa – i to nie tylko w laboratorium

Z rozwiązania korzysta już m.in. hiszpańsko-portugalski bank Abanca, który wdrożył hybrydowe środowisko: chmura do prototypowania, on-prem dla kodu produkcyjnego. Z kolei francuski gigant transportu, SNCF, dał dostęp 4000 programistów do wersji serwerless. Capgemini planuje wdrożenie lokalne dla 1500 programistów pracujących przy projektach dla branż regulowanych.

Czyli nie jest to tylko narzędzie „dla geeków z Doliny”, ale rozwiązanie sprawdzone w realnych, złożonych środowiskach.

Dziękujemy Continue, ale teraz czas na więcej

Zespół Mistral nie zapomina, komu zawdzięcza fundamenty – open-source’owa społeczność Continue była tu kluczowa. Ale teraz ten fundament został rozbudowany: dodano edycję wielu linii, czat, RBAC, logowanie audytowe, a także system przyjmowania sugestii i śledzenia ich rozwiązań.

I choć na razie dostęp mamy tylko w wersji beta, ogólna dostępność nadciąga niczym commit przed deadlinem sprintu.

Jak zacząć?

Wystarczy zgłosić się do zespołu Mistrala, wybrać model wdrożenia – chmurowy, serwerless albo on-premises – i… po prostu zacząć. Frontier-grade AI czeka.