Meta znów próbuje zamieszać na rynku sztucznej inteligencji. Firma Marka Zuckerberga ogłosiła premierę Llama 4 – nowej rodziny modeli AI, która zasila już Asystenta Meta dostępnego w przeglądarce, WhatsAppie, Messengerze i na Instagramie.

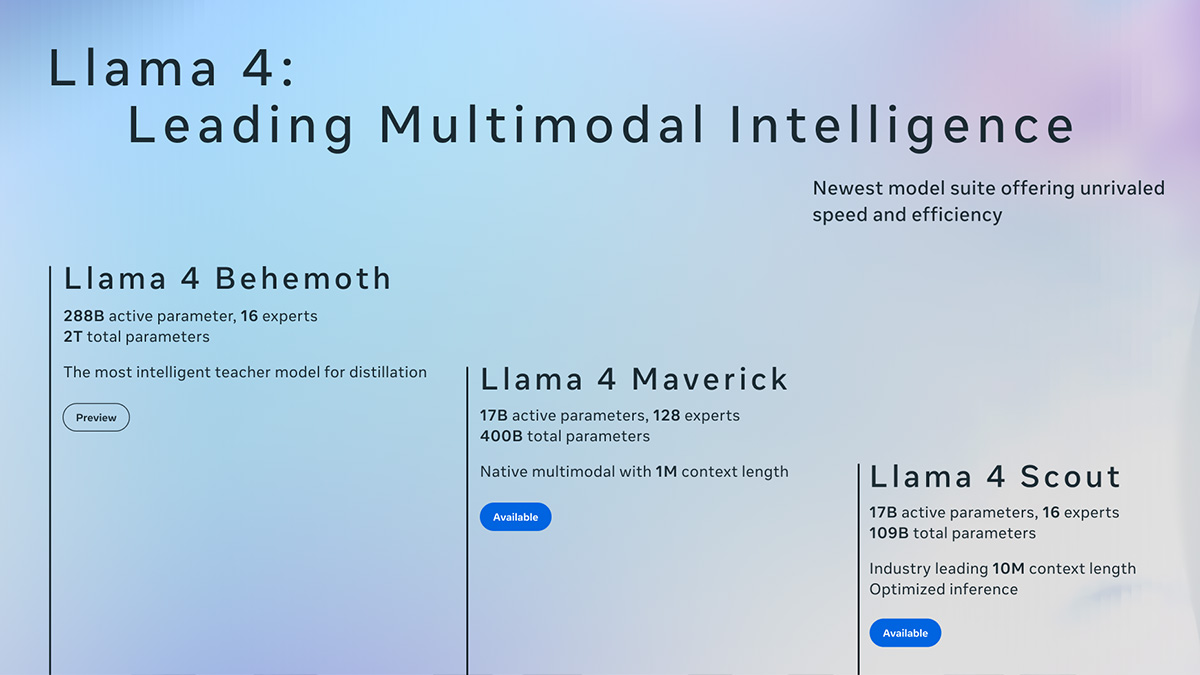

W skład kolekcji wchodzą dwa świeżo udostępnione modele: Llama 4 Scout oraz Llama 4 Maverick. Ten pierwszy to AI „na kieszeń” – jego największym atutem jest fakt, że mieści się w jednej karcie graficznej Nvidia H100. Drugi – Maverick – to już zawodnik wagi ciężkiej, śmiało konkurujący z GPT-4o od OpenAI czy Gemini 2.0 Flash od Google.

Ale to jeszcze nie koniec. Meta wciąż pracuje nad trzecim, największym z całej serii modelem – Llama 4 Behemoth. I nie bez powodu nazwano go potworem – model ma zawierać aż 2 biliony parametrów, z czego 288 miliardów aktywnych. Zuckerberg twierdzi, że to „najlepiej działający model bazowy na świecie”. Skromnie, prawda? Ciekawe ile z tego jest oparte na kradzionej treści…

Scout kontra reszta świata

Llama 4 Scout, mimo swojej kompaktowości, nie ma kompleksów. Model oferuje kontekst o długości 10 milionów tokenów – czyli pamięć roboczą, w której AI „myśli”. Meta chwali się, że Scout pokonuje takie modele jak Google Gemma 3, Gemini 2.0 Flash-Lite czy open-source’owy Mistral 3.1, i to w szerokim zakresie testów.

Llama 4 Maverick również ma ambicje – i zdaniem twórców, przewyższa GPT-4o czy Gemini 2.0 Flash, szczególnie w zadaniach związanych z kodowaniem i rozumowaniem, zużywając przy tym mniej niż połowę aktywnych parametrów. Trochę jakby mniej jeść, a i tak wygrywać maratony.

A co z Behemotem?

Tu robi się jeszcze ciekawiej. Llama 4 Behemoth ma szansę zdeklasować nawet GPT-4.5 i Claude Sonnet 3.7 – szczególnie w benchmarkach STEM, czyli zadań z nauk ścisłych i technicznych. Choć model nie został jeszcze udostępniony publicznie, już teraz wzbudza ogromne zainteresowanie w świecie AI.

Wszystkie modele z serii Llama 4 bazują na architekturze MoE (mixture of experts). To podejście, w którym do wykonania konkretnego zadania aktywowane są tylko niezbędne części modelu. Efekt? Oszczędność zasobów bez kompromisu na wydajności – jak dobrze dobrany zespół, w którym każdy robi to, co umie najlepiej.

Meta zapowiedziała, że więcej szczegółów zdradzi podczas LlamaCon, która odbędzie się 29 kwietnia. Jeśli nie planujesz wtedy niczego ważnego – warto zajrzeć. Bo zapowiada się gorąco.

Open-source? Tak, ale…

Meta ponownie określa Llama 4 jako „open-source”. Problem w tym, że nie wszystkim to się podoba. Licencja na korzystanie z modeli wymaga, by firmy z ponad 700 milionami aktywnych użytkowników miesięcznie uzyskały zgodę od Meta, zanim w ogóle ruszą z komercyjnym wdrożeniem. Open Source Initiative już wcześniej stwierdziła, że przez takie zapisy Llama „wypada z kategorii otwartego oprogramowania”.

Cóż – otwartość według Meta to trochę jak „otwórz lodówkę, ale nie ruszaj niczego bez pytania”.