Sztuczna inteligencja coraz śmielej wkracza do świata medycyny, ale to nie science fiction, tylko realna pomoc w codziennych obowiązkach lekarzy, diagnostów i programistów tworzących narzędzia zdrowotne. A teraz Google dorzuca do tego swoją cegiełkę – ba, raczej cały fundament. Przedstawia bowiem dwa nowe modele AI z rodziny MedGemma, które mają pomóc rozwinąć skrzydła twórcom narzędzi medycznych.

AI na zdrowie – dosłownie

Zanim jednak przejdziemy do nowości, małe przypomnienie. W maju Google zaprezentowało Health AI Developer Foundations (HAI-DEF) – zestaw lekkich i otwartych modeli AI do zastosowań medycznych. Otwartość tych modeli to klucz – deweloper może je dowolnie modyfikować, wdrażać lokalnie lub w chmurze, bez uzależniania się od API czy kaprysów zdalnych aktualizacji.

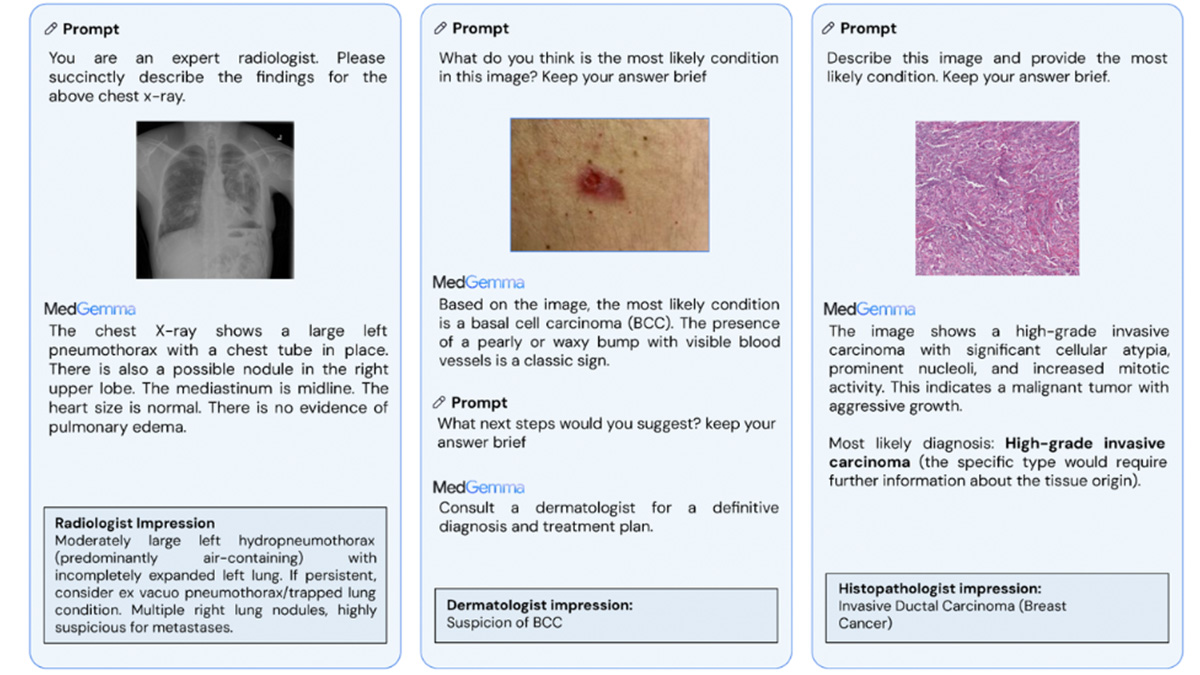

W ramach HAI-DEF pojawiła się kolekcja MedGemma – modele generatywne oparte na Gemma 3, zaprojektowane specjalnie z myślą o rozwoju AI w ochronie zdrowia i naukach biologicznych.

Nowi zawodnicy: MedGemma 27B Multimodal i MedSigLIP

Pierwsza nowość to MedGemma 27B Multimodal – potężny model potrafiący analizować złożone dane obrazowe i tekstowe, w tym rekordy zdrowotne prowadzone na przestrzeni czasu. Drugi to MedSigLIP – lekki (tylko 400M parametrów!), ale zwinny model do kodowania obrazów i tekstów, świetny w klasyfikacji i wyszukiwaniu obrazów medycznych.

Oba modele to silna para: MedGemma do zadań wymagających generowania tekstu (raporty, odpowiedzi na pytania wizualne), a MedSigLIP do tych, które wymagają precyzyjnych odpowiedzi w formacie strukturalnym (np. rozpoznawanie zmian chorobowych).

I nie potrzeba do tego wielkiego serwera! MedGemma 4B i MedSigLIP uruchomimy nawet na pojedynczym GPU – a po odpowiednich cięciach nawet na sprzęcie mobilnym.

MedGemma – mistrz słów i obrazów

W skład kolekcji wchodzą dwa główne warianty: MedGemma 4B Multimodal oraz MedGemma 27B (tekstowy i multimodalny). Ten pierwszy osiąga 64,4% na benchmarku MedQA, co czyni go jednym z najmocniejszych modeli w swojej klasie (<8B). Co więcej – aż 81% generowanych przez niego opisów zdjęć RTG klatki piersiowej uznano za równie przydatne jak oryginały przygotowane przez radiologów. Nieźle, jak na „sztuczną inteligencję”.

Wariant 27B idzie jeszcze dalej – uzyskuje wynik 87,7% na MedQA, blisko lidera DeepSeek R1, ale działa za ułamek kosztu obliczeniowego. Model radzi sobie nie tylko z pytaniami medycznymi, ale również z przetwarzaniem danych z dokumentacji elektronicznej.

MedSigLIP – ekspert od obrazów

MedSigLIP to bardziej wyspecjalizowany koleżka – potrafi „czytać” obrazy medyczne i przyporządkować je do tekstowych opisów. Niezależnie czy to zdjęcie z RTG, fragment tkanki z mikroskopu, czy siatkówka oka – poradzi sobie. W dodatku zachowuje dobrą formę również na obrazach naturalnych, co czyni go bardziej elastycznym niż modele szyte na jedną miarę.

Działa w klasycznych zadaniach klasyfikacyjnych, w trybie zero-shot (czyli „domyśl się bez treningu”) i przy przeszukiwaniu baz obrazów medycznych.

Otwarte, czyli dla każdego

Wszystkie modele z rodziny MedGemma są otwarte. Można je pobrać, zmodyfikować, dostosować do własnych potrzeb – i co ważne – nie trzeba martwić się o to, że po aktualizacji coś przestanie działać (API, patrzymy na was z ukosa). To bardzo istotne, szczególnie w środowisku medycznym, gdzie stabilność i powtarzalność wyników są na wagę złota.

Dla wygody użytkowników modele dostępne są na platformie Hugging Face w formacie safetensors – to taki bezpieczny lunchbox na dane.

I co teraz z tym robią?

Zainteresowanie rośnie. W DeepHealth (Massachusetts, USA) MedSigLIP pomaga w szybszym wykrywaniu guzków na zdjęciach RTG. W Tajwanie, w szpitalu Chang Gung, MedGemma wspomaga pracę z literaturą medyczną po chińsku. A w Indiach, zespół Tap Health docenił jego „kliniczne wyczucie”, przy podsumowywaniu notatek czy udzielaniu zaleceń zgodnych z wytycznymi.

Od testu do produkcji

Dla chętnych są gotowe notatniki na GitHubie pokazujące, jak modele uruchomić i fine-tune’ować. Można też zintegrować je bezpośrednio z platformą Vertex AI. A jeśli ktoś lubi demo zamiast teorii – Google przygotowało pokaz, jak MedGemma może pomóc w zbieraniu informacji przed wizytą u lekarza.

Krótko mówiąc: Google dorzuciło kilka bardzo konkretnych narzędzi do skrzynki z narzędziami dla każdego, kto buduje AI w medycynie. Modele są otwarte, lekkie, elastyczne – a mimo to osiągają wyniki, które robią wrażenie nawet na lekarzach z doświadczeniem. I to wszystko bez potrzeby dźwigania superkomputera w plecaku.