Odkrywanie ciemnych zakamarków sztucznej inteligencji: najnowsze badania rzucają światło na niepokojące zastosowania AI.

Wyobraź sobie świat, w którym nie możesz odróżnić prawdziwego Justina Biebera od jego cyfrowego klona, który śpiewa o zaletach jedzenia brokułów. Brzmi absurdalnie? Może i tak, ale to właśnie możliwości, jakie oferują deep fakes – jedno z najbardziej niepokojących zastosowań sztucznej inteligencji.

W najnowszym badaniu przeprowadzonym przez Google DeepMind oraz Jigsaw, inkubator technologiczny Google’a monitorujący zagrożenia społeczne, przeanalizowano nadużycia AI w okresie od stycznia 2023 do marca 2024 roku. Badanie objęło 200 rzeczywistych incydentów związanych z nadużyciem AI, z których najczęstszym okazało się tworzenie i rozpowszechnianie oszukańczych mediów deep fake, szczególnie tych, które mają na celu oczernianie polityków i osób publicznych.

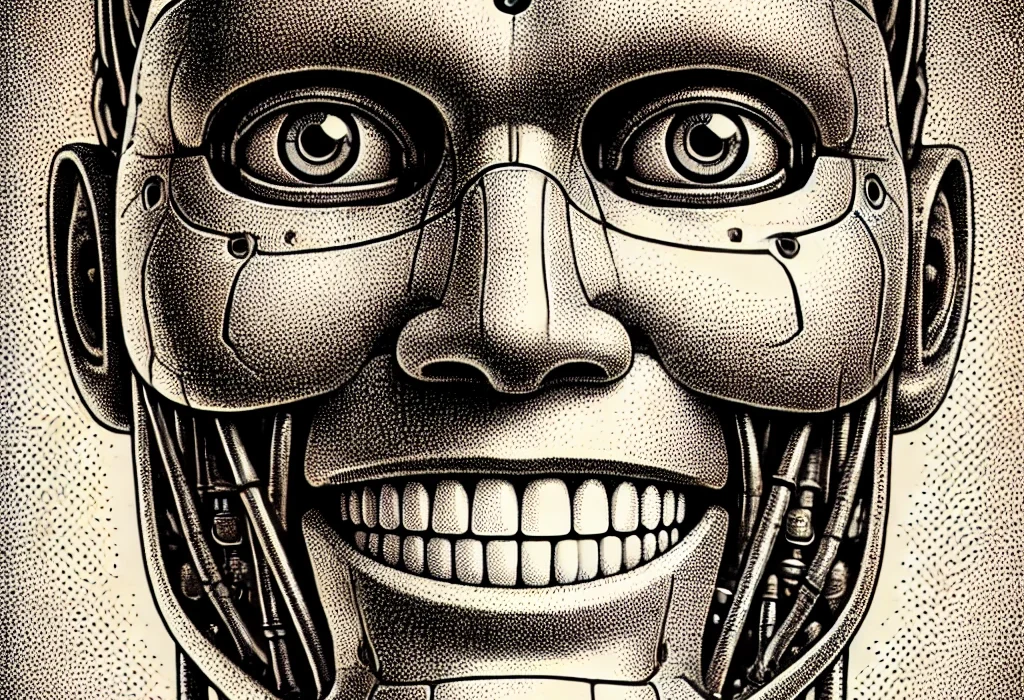

Deep fakes, czyli syntetyczne media generowane za pomocą algorytmów AI, które tworzą niezwykle realistyczne, ale fałszywe obrazy, filmy i dźwięki, stają się coraz bardziej życiowe i wszechobecne. Przykładem może być incydent z fałszywymi, eksplikacyjnymi obrazami Taylor Swift, które pojawiły się na platformie X i zdążyły dotrzeć do milionów osób zanim zostały usunięte.

Ale najbardziej podstępne są deep fakes skierowane na kwestie polityczne, takie jak konflikt izraelsko-palestyński. W niektórych przypadkach nawet fakt checkerzy, którzy mieli za zadanie oznaczać je jako „wygenerowane przez AI”, nie byli w stanie wiarygodnie ocenić ich autentyczności.

Badanie DeepMind zgromadziło dane z różnorodnych źródeł, w tym platform społecznościowych takich jak X i Reddit, blogów internetowych oraz raportów medialnych. Każdy incydent był analizowany pod kątem konkretnego typu technologii AI, której nadużyto, zamierzonego celu nadużycia oraz poziomu wiedzy technicznej wymaganej do przeprowadzenia działania szkodliwego.

Deep fakes okazały się dominującą formą nadużycia AI, stanowiąc prawie dwa razy więcej incydentów niż kolejna najczęściej obserwowana kategoria nadużyć. Drugim najczęściej obserwowanym typem nadużycia AI było wykorzystanie modeli językowych i chatbotów do generowania i rozpowszechniania dezinformacji online. Automatyzacja tworzenia wprowadzających w błąd treści pozwala złym aktorom zalewać media społecznościowe i inne platformy fałszywymi wiadomościami i propagandą na niespotykaną dotąd skalę.

Naginanie opinii publicznej i narracji politycznych było głównym motywem za ponad jedną czwartą (27%) analizowanych przypadków nadużycia AI. To odkrycie podkreśla poważne zagrożenie, jakie deepfakes i dezinformacja generowana przez AI stanowią dla procesów demokratycznych i integralności wyborów na całym świecie.

Zysk finansowy został zidentyfikowany jako drugi najczęstszy motyw szkodliwej działalności AI, z nieuczciwymi aktorami oferującymi płatne usługi do tworzenia deep fakes, w tym obrazów bez zgody, oraz wykorzystując generatywną AI do masowej produkcji fałszywych treści dla zysku.

Większość incydentów nadużycia AI wiązała się z łatwo dostępnymi narzędziami i usługami, które wymagały minimalnej wiedzy technicznej do obsługi. Ta niska bariera wejścia znacznie rozszerza pulę potencjalnych szkodliwych aktorów, ułatwiając im zaangażowanie w oszustwa i manipulacje wspomagane przez AI.

Obecnie firmy technologiczne nie są w stanie wiarygodnie wykrywać deep fakes na dużą skalę, a te będą tylko stawać się bardziej realistyczne i trudniejsze do wykrycia. A kiedy systemy tekstowo-wideo, takie jak Sora od OpenAI, wejdą na rynek, pojawi się całkiem nowy wymiar deep fakes do obsługi. Czy jesteśmy gotowi na to wyzwanie? Czas pokaże, ale na razie wygląda na to, że deep fakes mają nas w swoim cyfrowym uścisku.