Kiedyś, żeby spojrzeć na świat z góry, trzeba było wspiąć się na wieżę albo… zostać ptakiem. Dziś wystarczy model AI i garść danych satelitarnych. A jeśli dobrze to wszystko doprawimy – najlepiej szczyptą fine-tuningu – to otrzymamy narzędzie, które nie tylko patrzy, ale też rozumie. Tak właśnie zadziałało to w przypadku modelu Pixtral-12B, który po odpowiednim dostrojeniu zyskał zupełnie nowe możliwości w analizie zdjęć satelitarnych.

LoRA – mniej znaczy więcej

Tradycyjne fine-tuning dużych modeli AI potrafi być jak remont generalny – kosztowny, czasochłonny i czasem po prostu niepotrzebny. Dlatego na scenę wchodzi LoRA, czyli Low-Rank Adaptation – technika, która pozwala na dostrojenie modelu bez modyfikowania wszystkich jego parametrów. Zamiast zmieniać wszystko, LoRA „dokleja” niewielkie, uczące się matryce do istniejących wag. Efekt? Oszczędność zasobów i znacznie większa precyzja w działaniu modelu w konkretnych kontekstach.

To rozwiązanie jest szczególnie przydatne tam, gdzie prompt engineering (czyli sztuka pisania magicznych zdań do AI) przestaje wystarczać. Zamiast pisać eseje do modelu, wystarczy kilka starannie dobranych przykładów – resztę załatwia fine-tuning.

Zdjęcia z orbity wymagają specjalistów

Obraz satelitarny to nie selfie z wakacji. Rozmazana plama może być fabryką, lasem albo… osiedlem domków jednorodzinnych. Takie dane są kluczowe m.in. dla rolnictwa, obronności czy monitorowania zmian klimatycznych. Nic więc dziwnego, że ogólne modele wizji komputerowej, które nigdy nie widziały mapy z orbity, gubią się w szczegółach. Dlatego właśnie Pixtral-12B został przystosowany do zadań związanych z analizą zdjęć satelitarnych – by przekształcić ogólną inteligencję w eksperta od patrzenia z kosmosu.

Studium przypadku: Aerial Image Dataset

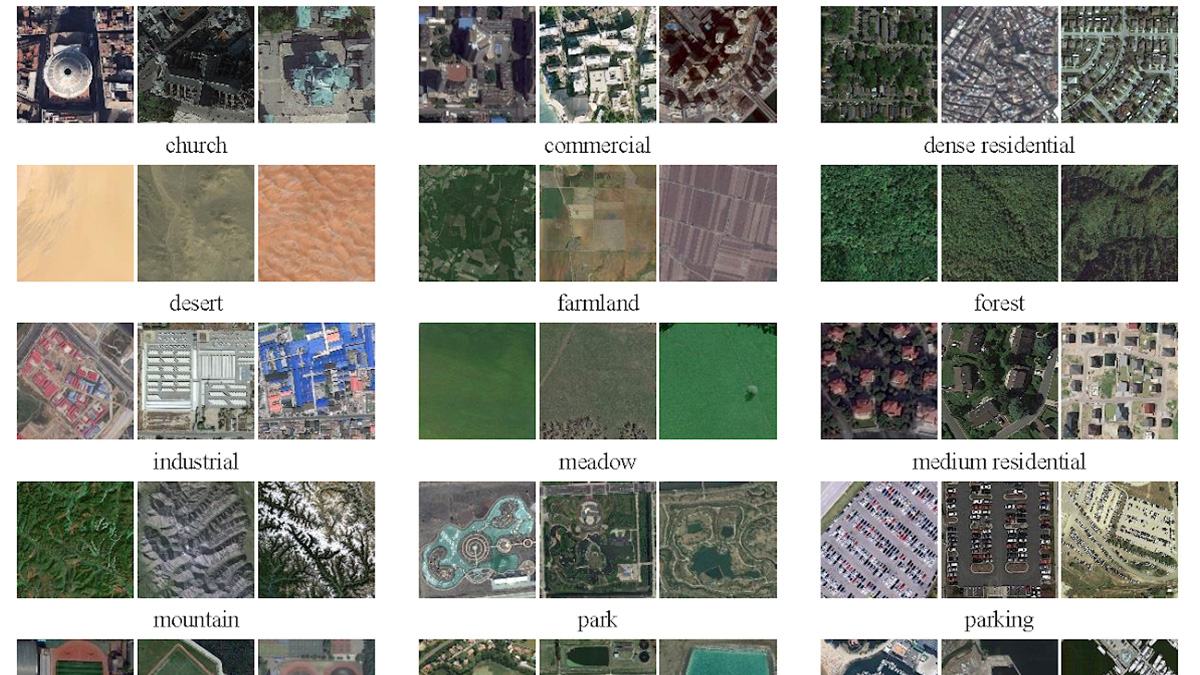

Aby udowodnić skuteczność tego podejścia, wykorzystano zestaw danych Aerial Image Dataset (AID) – popularny benchmark zawierający zdjęcia lotnicze przypisane do konkretnych klas (np. „gęsta zabudowa”, „centrum”, „stadion” itd.). Problem? Wiele z tych klas to wizualne bliźniaki – odróżnienie „placu zabaw” od „stadionu” potrafi zmylić nawet człowieka bez doświadczenia.

Bazowy model Pixtral-12B bez fine-tuningu osiągał przyzwoite wyniki – ale tylko w ogólnych kategoriach. Im większa dwuznaczność, tym częściej model się mylił, czasem nawet halucynując – czyli wymyślając nieistniejące klasy. Klasyka problemów dużych modeli językowych.

Po fine-tuningu? Skok jak z orbity

Z pomocą przyszła platforma Mistral i jej API do fine-tuningu, które – jak zapewniają twórcy – działa niemal jak „dostosuj i kliknij”. Użytkownik podaje prompt, obraz i odpowiedź – resztę załatwia system. Bez konieczności żonglowania hiperparametrami czy budżetami jak z NASA.

Efekt? Skok dokładności z 56% do 91%, spadek liczby halucynacji z 5% do 0,1%, a to wszystko przy budżecie poniżej 10 dolarów. Czasem naprawdę niewiele trzeba, żeby model zobaczył więcej niż tylko piksele.

A to dopiero początek

Sukces z Pixtral-12B to dowód na to, że dobrze przeprowadzony fine-tuning potrafi odmienić oblicze dużych modeli AI – nie tylko dla zdjęć satelitarnych. Te same techniki mogą być zastosowane wszędzie tam, gdzie dane są zbyt niszowe, by załapały się do ogólnego treningu modeli. Diagnostyka medyczna, analiza rękopisów, obrazy z kamer przemysłowych? Jak najbardziej. Klucz tkwi w specjalizacji.

A skoro nawet model językowy potrafi dziś rozróżnić plac zabaw od stadionu – to kto wie, może jutro rozpozna nie tylko co jest na zdjęciu, ale też dlaczego warto się tam wybrać?