Sztuczna inteligencja w kodowaniu przeszła już długą drogę od autouzupełniania nawiasów do rozwiązywania rzeczywistych problemów z GitHuba. A teraz pojawia się Devstral – nowy gracz na boisku agentowych LLM-ów, który nie tylko zna zasady gry, ale też potrafi strzelać bramki z połowy boiska.

Za jego powstanie odpowiadają Mistral AI i All Hands AI 🙌 – duet, który postawił sobie za cel przekształcenie modeli językowych w pełnoprawnych partnerów w procesie wytwarzania oprogramowania. I jak się okazuje – nie rzucają słów na wiatr.

Kodowanie, ale z kontekstem

Typowe LLM-y radzą sobie dobrze z drobnymi zadaniami – napiszą funkcję, dokończą fragment kodu. Ale kiedy przychodzi do prawdziwej roboty, jak przeszukiwanie złożonego repozytorium czy wyłapywanie ukrytych błędów logicznych w dużych projektach – rozkładają ręce. No właśnie, tu wchodzi Devstral, cały na agentowo.

Zamiast tylko odpowiadać na proste prompt’y, Devstral działa w oparciu o tzw. scaffolding agentowy (jak OpenHands czy SWE-Agent), który łączy go z realnymi testami i kodem. Mówiąc prościej: model nie zgaduje co by mogło działać, tylko sprawdza, testuje i poprawia.

Wyniki nie kłamią

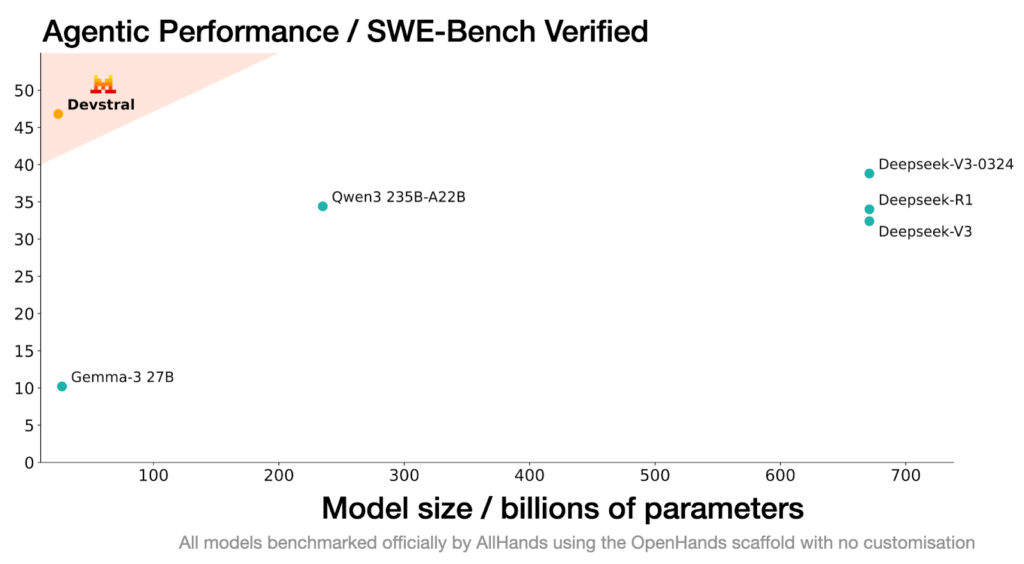

Na benchmarku SWE-Bench Verified – zestawie 500 rzeczywistych problemów z GitHuba, które zostały ręcznie zweryfikowane – Devstral osiągnął wynik 46,8%. To o ponad 6 punktów procentowych lepiej niż poprzedni open-source’owy lider. Co więcej, przewyższa również gigantów pokroju Deepseek-V3-0324 (671B!) czy Qwen3 232B-A22B, pomimo znacznie mniejszego rozmiaru.

Gdyby to był konkurs szachowy, można by powiedzieć, że Devstral ograł przeciwników grając jedną ręką. A przy okazji nie zapomniał, jak się mówi „mat” po łacinie.

Lekki jak MacBook, mocny jak serwer

Devstral działa nawet lokalnie – wystarczy RTX 4090 albo Mac z 32 GB RAM. Żadna tam chmura ani klaster GPU. To oznacza, że programiści mogą pracować z nim na własnych maszynach, bez obaw o prywatność kodu. Idealna opcja dla firm, które mają bardziej restrykcyjne wymagania compliance niż NASA przy starcie promu.

Ale to nie wszystko. Devstral świetnie sprawdzi się jako silnik w agentowych IDE, wtyczkach czy środowiskach kodowania. Gdziekolwiek chcesz mieć mądrego pomocnika, który nie tylko wie, co robisz, ale też rozumie, dlaczego.

Dostępność i licencja

Devstral jest dostępny bezpłatnie na licencji Apache 2.0 – można go pobrać, modyfikować, a nawet uczyć dalej. Model znajdziecie na HuggingFace, Ollama, Kaggle, Unsloth czy LM Studio. A jeśli ktoś woli dostęp przez API – proszę bardzo, dostępny pod nazwą devstral-small-2505 w tej samej cenie co Mistral Small 3.1 ($0.1/M tokenów wejściowych i $0.3/M wyjściowych).

Dla większych firm jest też opcja dalszego dostrajania modelu – wystarczy skontaktować się z zespołem All Hands AI.

Co dalej?

Obecny Devstral to wersja badawcza, ale już teraz robi spore wrażenie. W planach jest jego większy brat – jeszcze bardziej agentowy, jeszcze mądrzejszy. Można by powiedzieć, że Devstral to dopiero przystawka, a danie główne dopiero się gotuje.