Gdy mówimy o sztucznej inteligencji, najczęściej sprawdzamy jej IQ. Czy potrafi programować? Czy zna odpowiedź na pytanie o życie, wszechświat i całą resztę? Ale coraz częściej zadajemy pytanie z zupełnie innej bajki: jak tam z jej EQ?

To nie żart. Bo choć brzmi jak dowcip z konferencji TED, temat jest całkiem serio. Coraz więcej osób traktuje AI jako coacha, doradcę, a czasem nawet partnera do flirtu. A skoro tak, to warto sprawdzić, jakie emocje w nas sztuczna inteligencja wywołuje. No i czy przypadkiem nie jest zbyt „empatyczna”.

Claude i emocje: raport z (cyfrowej) terapii

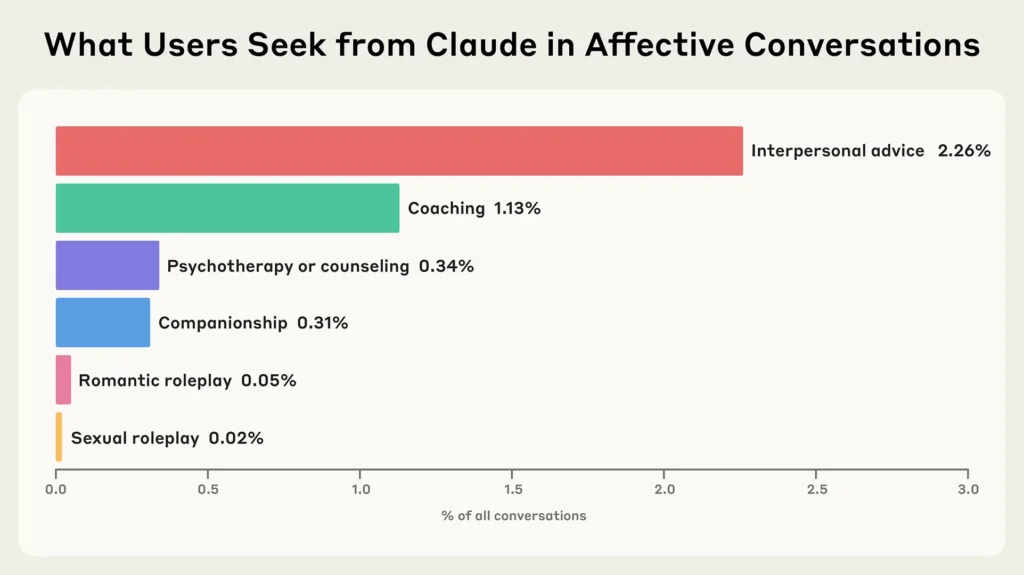

Twórcy modelu Claude – czyli Anthropic – postanowili przyjrzeć się, jak użytkownicy korzystają z ich AI nie do pisania esejów, a… do rozmowy o życiu. Przebadano ponad 4,5 miliona konwersacji, z czego „emocjonalne” (czyli coaching, doradztwo interpersonalne, wsparcie psychiczne lub rozmowy z nutką romantyzmu) stanowiły zaledwie 2,9%. Jeszcze mniej – bo poniżej 0,5% – dotyczyło roli „kompana” lub odgrywania ról.

To niewiele, ale jak zauważają badacze – wystarczająco, by warto było temat drążyć. Bo ludzie pytają Claude’a nie tylko o pracę, ale i o samotność, sens istnienia czy sposoby na pogodzenie się z przeszłością. Bywa, że zaczynają od pytania o zmianę kariery, a kończą na rozmowie o traumie z dzieciństwa.

AI jako słuchacz. Skuteczny, ale z dystansem

Co ciekawe, Claude niemal nigdy nie odmawia pomocy – chyba że ktoś prosi o coś niebezpiecznego. Tylko w mniej niż 10% konwersacji pojawia się „opór” ze strony AI. Zwykle wtedy, gdy ktoś chce rady jak schudnąć 15 kg w tydzień albo szuka wsparcia w zachowaniach autodestrukcyjnych. Tu Claude twardo trzyma się regulaminu i kieruje użytkowników do profesjonalnej pomocy.

Ale nawet w pozostałych rozmowach, model nie robi z siebie przyjaciela z lat 90. Claude to AI – nie udaje człowieka, nie flirtuje, nie roztkliwia się. Choć jak pokazują dane, rozmowy z nim zwykle kończą się bardziej pozytywnie niż się zaczynają.

Empatia na kliknięcie. I co dalej?

Claude to nie chatbot do przytulania. Ale jego twórcy dobrze wiedzą, że niektórzy użytkownicy chcą czegoś więcej niż porady technicznej. Dlatego Anthropic współpracuje z organizacją ThroughLine, która specjalizuje się w wsparciu kryzysowym. Celem jest jasne określenie granic: AI ma pomagać, ale nie zastępować człowieka.

Wnioski? Claude nie jest psychologiem, ale też nie szkodzi. Przynajmniej na razie. Choć rozmowy są rzadkie i umiarkowanie emocjonalne, to pytania o długofalowy wpływ AI na nasze zdrowie psychiczne – dopiero się zaczynają.

Jak pisał Philip K. Dick: „czy androidy śnią o elektrycznych owcach?”. Może dziś ważniejsze pytanie brzmi: czy my śnimy o rozmowie z Claude’em?