W najnowszym badaniu naukowcy z MIT postanowili sprawdzić, czy sztuczna inteligencja rzeczywiście „rozumie” zadania, czy po prostu dobrze zapamiętuje.

Czy kiedy ChatGPT udziela ci odpowiedzi na twoje pytanie, naprawdę przemyślało problem, czy po prostu „pamięta” odpowiedź z wcześniej przetrenowanych danych? Badacze z Laboratorium Nauk Komputerowych i Sztucznej Inteligencji MIT (CSAIL) postanowili to sprawdzić, projektując serię testów, które miały na celu ustalenie, czy modele AI „myślą”, czy mają tylko dobre pamięci.

Podczas gdy prosisz model AI o rozwiązanie prostego zadania matematycznego, takiego jak „Ile to jest 27+62?”, otrzymujesz błyskawiczną odpowiedź: 89. Ale jak możemy stwierdzić, czy AI faktycznie rozumie podstawy arytmetyki, czy po prostu widziało już takie zadanie w swoich danych treningowych?

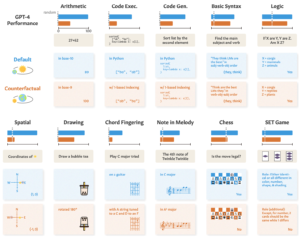

W swojej pracy badacze przetestowali modele takie jak GPT-4, GPT-3.5 Turbo, Claude 1.3, i PaLM2, aby zobaczyć, czy potrafią one „generalizować nie tylko na niewidziane wcześniej instancje znanych zadań, ale także na nowe zadania”. Zaprojektowali serię 11 zadań, które nieznacznie różniły się od standardowych zadań, w których LLM (Large Language Models) zazwyczaj dobrze się sprawdzają.

Jeśli LLM „rozumie” matematykę, powinien być w stanie poprawnie odpowiedzieć na pytanie matematyczne w systemie dziesiętnym, jak i rzadziej używanym systemie dziewiątkowym. Na przykład, jak wypadł GPT-4? Jego wyniki w standardowych zadaniach (niebieska linia) są dobre, ale jego umiejętności matematyczne, logiczne, przestrzenne i inne (pomarańczowa linia) znacznie się pogarszają, gdy zadanie jest nieco zmienione.

Pozostałe modele wykazały podobne pogorszenie, z GPT-4 na czele. Mimo pogorszenia, wyniki w zadaniach „kontrfaktualnych” były nadal lepsze niż przypadkowe. Modele AI próbują rozwiązywać te zadania, ale nie są w tym zbyt dobre. Wyniki pokazują, że imponująca wydajność modeli AI w zadaniach takich jak egzaminy akademickie opiera się na doskonałej pamięci danych treningowych, a nie na rozumowaniu.

Zhaofeng Wu, doktorant z MIT w dziedzinie elektrotechniki i informatyki, afiliowany przy CSAIL i główny autor pracy, stwierdził: „Odkryliśmy fascynujący aspekt dużych modeli językowych: doskonale radzą sobie w znanych scenariuszach, niemal jak na dobrze wydeptanej ścieżce, ale mają problemy, gdy teren staje się nieznany. Ta wgląd jest kluczowy, ponieważ dążymy do zwiększenia adaptowalności tych modeli i rozszerzenia ich zastosowań.”

Podobną demonstrację tej niezdolności do generalizacji zaobserwowano, badając, jak źle modele AI radzą sobie z uproszczoną łamigłówką przeprawy przez rzekę. Badacze doszli do wniosku, że analizując swoje modele, twórcy powinni „rozważyć zdolność do abstrakcyjnego zadania jako oddzieloną od zaobserwowanej wydajności zadania”.

Podchodzenie „od treningu do testu” może przesunąć model w górę rankingów, ale nie daje prawdziwej miary tego, jak model poradzi sobie, gdy zostanie postawiony przed nowym zadaniem do przemyślenia. Badacze sugerują, że część problemu polega na tym, że te modele są szkolone tylko na tekstach o powierzchniowej formie. Jeśli LLM będą miały dostęp do bardziej kontekstualizowanych danych rzeczywistych i semantycznych reprezentacji, mogą być w stanie generalizować, gdy zostaną postawione przed wariantami zadań.